Yapay Zeka GPU ile GeForce GPU Farkı Ne?

Günümüz teknolojisinde, GPU (Graphics Processing Unit), sadece oyunlar için değil, birçok farklı alanda hayati bir rol oynamaktadır.

Yapay zeka (AI) uygulamaları için tasarlanan GPU’lar ile GeForce serisi GPU’lar arasındaki temel farklar, kullanım alanları, mimari özellikler ve performansta yatmaktadır.

AI GPU’ları, özellikle yapay zeka ve makine öğrenimi (ML) görevleri için optimize edilmiştir, büyük veri kümeleriyle çalışmak, derin öğrenme modelleri eğitmek ve çıkarım yapmak için yüksek paralel işlem gücü ve özel tensor çekirdekleri sunar. GeForce GPU’lar ise daha çok oyun ve grafik işleme için tasarlanmış olup, gerçek zamanlı grafik optimizasyonuna odaklanır ve daha uygun fiyatlarla daha küçük ölçekli AI projelerinde kullanılabilir. AI GPU’ları yüksek bellek kapasitesine ve enerji verimliliğine sahipken, GeForce GPU’lar daha düşük fiyatlıdır ve daha yaygın bulunur.

Günümüz teknolojisinde, GPU (Graphics Processing Unit), sadece oyunlar için değil, birçok farklı alanda hayati bir rol oynamaktadır. Ancak, GPU’ların dünyasında, iki terim sıklıkla karşımıza çıkar: Yapay Zeka GPU’lar ve GeForce GPU’lar. Bu iki terim arasında ne gibi farklar olduğunu anlamak, doğru teknolojiyi seçmek isteyenler için oldukça önemli. Gelin, bu farkları daha derinlemesine keşfedelim.

Yapay Zeka GPU’lar ve GeForce GPU’lar Arasındaki Temel Farklar

Yapay Zeka ve GeForce GPU’ları, temelde aynı cihaz olsalar da, kullanım amaçları ve özellikleri bakımından önemli farklılıklar gösterirler.

| Özellik | Yapay Zeka GPU’ları | GeForce GPU’ları |

|---|---|---|

| Kullanım Amacı | Yapay zeka ve makine öğrenmesi uygulamaları | Oyunlar, video düzenleme, 3D modelleme ve grafik işleme |

| Hedef Kullanıcı | Araştırmacılar, veri bilimciler, profesyonel yapay zeka mühendisleri | Oyun severler, içerik üreticiler, profesyonel grafik tasarımcılar |

| Optimizasyon | Derin öğrenme, sinir ağları, büyük veri setleri üzerine optimize | Yüksek çözünürlüklü oyunlar, grafik render, ray tracing |

| Performans | Yüksek paralel hesaplama gücü, büyük veri işleme yeteneği | Yüksek grafik çözünürlüğü ve akıcı oyun deneyimi |

| Öne Çıkan Teknolojiler | Tensor çekirdekleri, yüksek bant genişliği, büyük bellek | Ray tracing, DLSS (Deep Learning Super Sampling) |

| Özelleşmiş Kullanım | Genellikle araştırma ve geliştirme, yapay zeka eğitimleri | Oyunlar ve grafik tabanlı uygulamalar |

| Popüler Modeller | NVIDIA Tesla, A100, V100 | NVIDIA GeForce RTX 30 Serisi, GTX Serisi |

| Fiyat | Genellikle yüksek (Profesyonel kullanım) | Orta seviye ile yüksek arasında değişen fiyatlar |

| Hafıza | Yüksek bellek kapasitesi (gerekli veri işleme için) | Orta seviye bellek kapasitesi (grafik işlemleri için yeterli) |

| Paralel İşlem | Çok sayıda işlem birimi ile yüksek paralel hesaplama gücü | Yüksek paralel işlem, ancak grafik odaklı |

| Veri Merkezi Kullanımı | Yaygın olarak veri merkezlerinde kullanılır | Genellikle bireysel bilgisayarlarda kullanılır |

GPU Nedir ve Neden Önemlidir?

GPU, bilgisayar grafiklerini işlemek için tasarlanmış bir donanım birimidir. Ancak, günümüzde GPU’lar sadece grafik işleme ile sınırlı kalmamış, çok daha geniş bir kullanım yelpazesine yayılmaktadır. Özellikle oyun dünyasında, görsel efektlerin, ışıklandırmaların ve animasyonların yönetilmesinde büyük bir öneme sahiptir.

Birçok uygulama ve işlemde, CPU (Central Processing Unit) ile birlikte çalışan GPU’lar, paralel işlem yapabilme yetenekleri sayesinde hızlı ve verimli sonuçlar üretirler. Ancak GPU’ların türü, kullanım amacına göre değişir. İşte burada devreye Yapay Zeka GPU’ları ve GeForce GPU’lar giriyor.

Yapay Zeka GPU’ları Ne İşe Yarar?

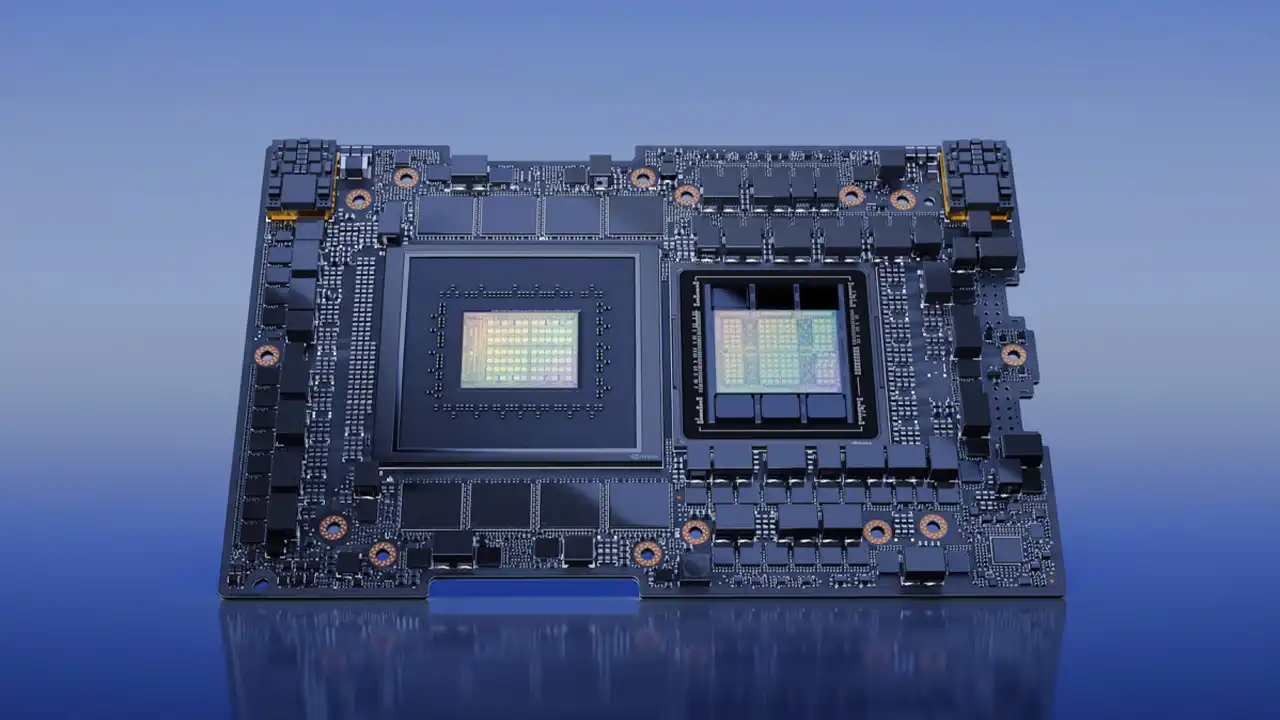

Yapay Zeka GPU’ları, özellikle yapay zeka (AI) ve makine öğrenmesi (ML) uygulamaları için özel olarak tasarlanmış bir donanım türüdür. Bu GPU’lar, büyük veri kümeleri üzerinde hızlı hesaplamalar yaparak, yapay zekâ algoritmalarının daha verimli çalışmasına olanak tanır. Özellikle derin öğrenme, doğal dil işleme (NLP) ve görüntü tanıma gibi alanlarda oldukça yaygın kullanılırlar.

Yapay Zeka GPU’ları, çok sayıda hesaplama görevini aynı anda yerine getirebilen paralel işleme yetenekleriyle dikkat çeker. Bu özellik, onların makine öğrenme modellerini eğitirken büyük miktarda veriyi hızlıca işleyebilmesini sağlar. NVIDIA’nın Tesla serisi veya A100 gibi ürünler, genellikle veri merkezlerinde ve araştırma laboratuvarlarında kullanılır.

GeForce GPU’lar Ne İşe Yarar?

GeForce GPU’lar ise, esas olarak oyun dünyasında kullanılır. Ancak yalnızca oyunlar için değil, aynı zamanda video düzenleme, 3D modelleme gibi alanlarda da yüksek performans gerektiren işlerde kullanılırlar. GeForce serisi, Nvidia’nın en bilinen ve en çok tercih edilen tüketiciye yönelik GPU’larından biridir. Oyun severler, GeForce GPU’ları sayesinde ultra yüksek çözünürlüklerde, akıcı oyun deneyimlerinin tadını çıkarır.

GeForce GPU’ları, genellikle grafik işleme konusunda optimize edilmişken, yapay zeka ve derin öğrenme uygulamaları için o kadar da verimli değillerdir. Ancak, son yıllarda GeForce RTX serisi, AI özellikleriyle donatılmıştır ve bu sayede bazı yapay zeka görevlerinde de kullanılabilir hale gelmiştir. Fakat bu GPU’lar, özellikle profesyonel yapay zeka uygulamaları için tasarlanmış olan modeller kadar güçlü değildir.

Kullanım Amacına Göre Farklılıklar

Yapay Zeka GPU’ları ve GeForce GPU’ları arasındaki farkları anlamanın en iyi yolu, her iki tip GPU’nun hangi amaçla kullanıldığını incelemektir.

Yapay Zeka GPU’ları için Optimizasyon

Yapay Zeka GPU’ları, yapay zeka modellerinin eğitilmesi ve çalıştırılması için optimize edilmiştir. Bu GPU’lar, çok büyük veri setleri üzerinde eğitim yapabilme yeteneği ile dikkat çeker. Makine öğrenmesi algoritmalarında, özellikle sinir ağlarını çalıştırırken, paralel hesaplama gücü çok önemlidir. Bu noktada, Yapay Zeka GPU’ları, işlemciye kıyasla çok daha hızlı ve verimli bir performans sağlar.

Yapay zeka uygulamalarında verinin hızı, doğru ve hızlı bir şekilde işlenmesi, başarının anahtarıdır. Bu nedenle, AI GPU’ları yüksek bant genişliği, çok sayıda CUDA çekirdeği ve büyük bellek gibi özelliklerle donatılmıştır.

GeForce GPU’larının Oyun ve Grafik Performansı

GeForce GPU’ları ise esas olarak oyunlar ve grafiklerle ilgilenir. Oyun dünyasında, bir oyun ne kadar görsel açıdan zenginse, o kadar fazla işlem gücüne ihtiyaç duyar. GeForce GPU’ları, yüksek çözünürlüklerde ve yüksek kare hızlarında oyun oynamak isteyen oyuncular için mükemmeldir.

GeForce RTX serisi ise, ray tracing (ışın izleme) gibi ileri düzey grafik teknolojilerine sahip olup, oyunlardaki görsel kaliteyi zirveye taşır. Bununla birlikte, video düzenleme, 3D render ve animasyon üretme gibi görevlerde de çok yüksek performans sergiler.

Teknik Farklılıklar ve Mimariler

Yapay Zeka GPU’ları ile GeForce GPU’larının teknik yapıları da farklıdır. Bu farklar, her iki GPU’nun performansını ve kullanım alanlarını doğrudan etkiler.

Yapay Zeka GPU’larının Teknik Yapısı

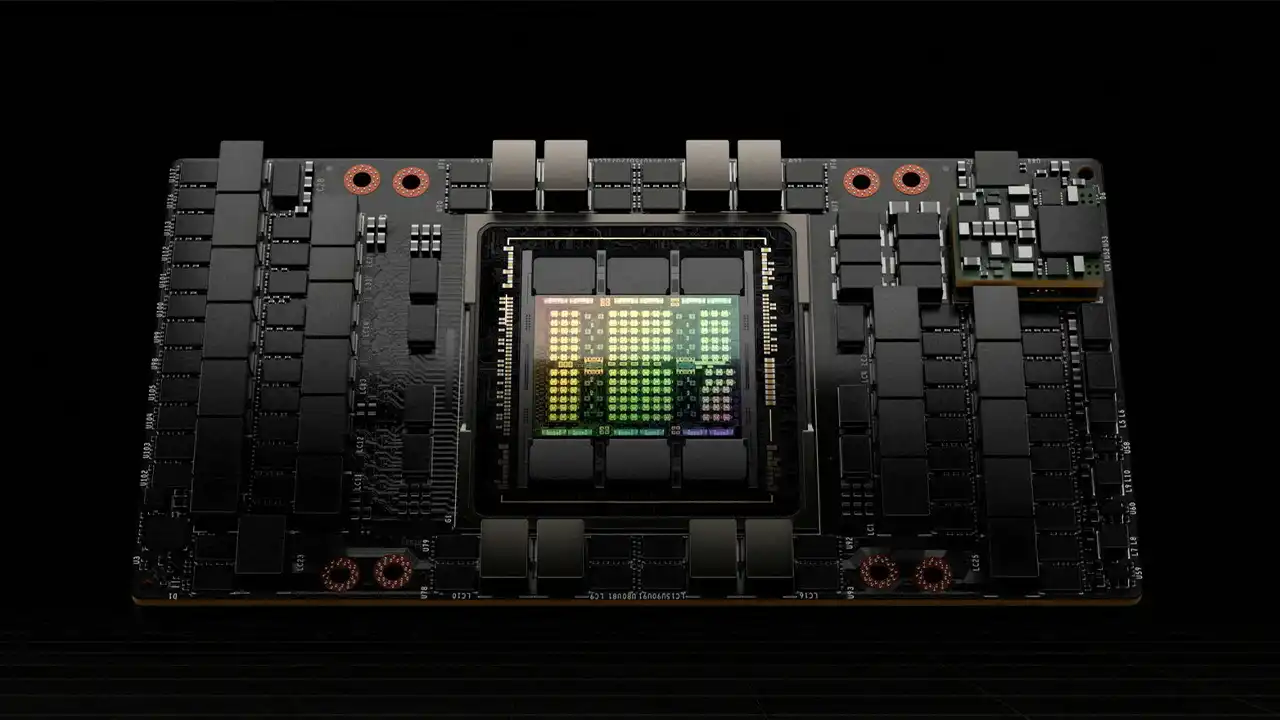

Yapay Zeka GPU’ları, genellikle çok çekirdekli mimarilere sahiptir. NVIDIA’nın Tensor çekirdekleri, bu tür GPU’ların yapay zeka algoritmalarını çalıştırmasında büyük rol oynar. Bu çekirdekler, özellikle matris çarpanları ve derin öğrenme hesaplamalarını çok hızlı bir şekilde yapabilen özel donanım birimleridir.

Bunlar, işlemciye kıyasla çok daha verimli bir şekilde paralel hesaplamalar yapabilir. Ayrıca, büyük veri setlerini işlemek için optimize edilmiş bellek yapıları ve veri aktarım hızları sunar. Yapay Zeka GPU’ları, karmaşık hesaplamalar gerektiren uygulamalarda çok daha yüksek verimlilik sağlar.

GeForce GPU’larının Teknik Yapısı

GeForce GPU’ları ise, genellikle grafik işlemleri için optimize edilmiştir. GeForce RTX serisi, ışın izleme (ray tracing) teknolojisini destekler ve bu sayede oyunlarda daha gerçekçi ışıklandırmalar ve gölgeler elde edilebilir. GeForce GPU’ları, aynı zamanda DLSS (Deep Learning Super Sampling) gibi yapay zeka destekli özelliklerle donatılmıştır.

GeForce GPU’ları, yapay zeka uygulamalarında da kullanılabilir, ancak bu kullanım, profesyonel yapay zeka GPU’larına kıyasla daha sınırlıdır. GeForce GPU’ları, oyunlar ve grafik işlemleri için en iyi performansı sunar, ancak büyük veri setleri ve karmaşık yapay zeka modelleri için optimize edilmemiştir.